AnarchIA

Miseria delle illusioni riformiste sull’intelligenza artificiale

∞

Appelli e contro-appelli

Mentre in Italia abbiamo sperimentando il (facilmente aggirabile e appena concluso) blocco di ChatGPT – non a causa della tecnofobia del Bel Paese, come strillato da alcun* su varie testate, ma per la semplice applicazione, da parte del Garante, delle normative vigenti sulla privacy – in tutto il mondo ha fatto discutere , firmato tra gli altri, praticamente in veste di frontman, anche da Elon Musk.

L’oggetto di tale appello è il rapidissimo recente sviluppo delle tecnologie di intelligenza artificiale e machine learning, oltre a un certo grado di imprevedibilità del loro impatto nel prossimo futuro dell’umanità. Il rischio paventato è quello che le IA sfuggano al controllo degli esseri umani e che i loro effetti possano sconvolgere tutta una serie di ambiti della vita umana come la conosciamo, tanto da rappresentare una sorta di vero e proprio rischio esistenziale.

La prima cosa da chiedersi, prima ancora di interrogarsi sull’eventuale cattiva coscienza dei firmatari – cosa che, spoiler, intendo fare in conclusione –, è se tale visione apocalittica sia o meno giustificata. Quella della creatura che sfugge al creatore è una narrazione per nulla nuova: si può partire dalle leggende ebraiche sul Golem, protettore di pietra animata che finisce per non voler più obbedire agli ordini, fino ad arrivare alle fantascientifiche rivolte delle macchine, passando per il “mostro” di Frankenstein raccontato da Mary Shelley. Il monito di Musk & Co., tuttavia, sembra ammantarsi di meno panico scomposto e più buonsenso: non siamo del tutto in grado di immaginare le conseguenze di questa rapida crescita delle IA, quindi fermiamoci un attimo, apriamo un dibattito pubblico, predisponiamo misure di sicurezza e poi ripartiamo.

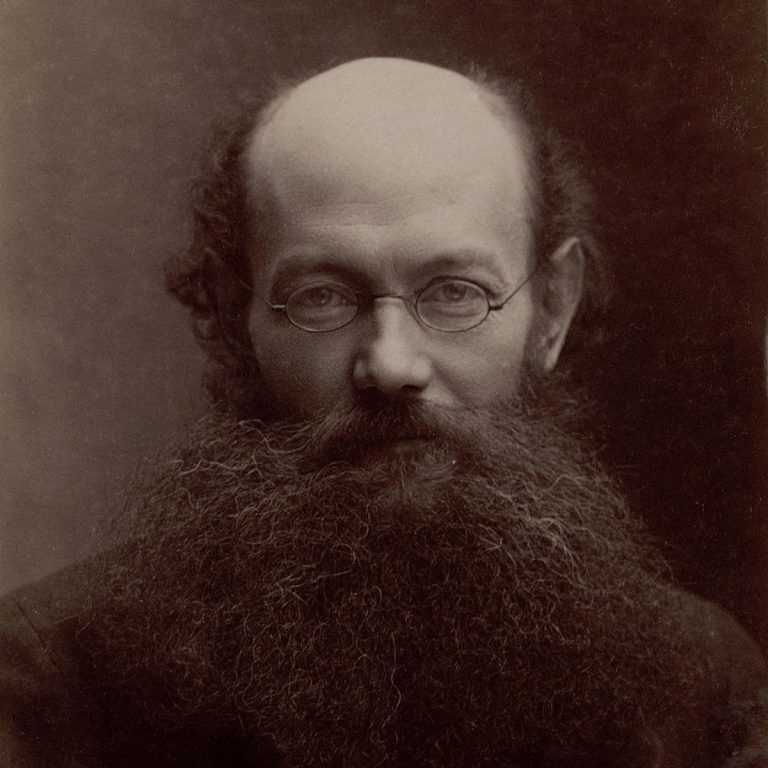

Scomodando un autore (molto pessimista) che dubito sia tra i riferimenti ideali dell’appello, possiamo dire che questa strategia riecheggia il richiamo all’inazione di Günther Anders. Il filosofo tedesco, primo marito di Hanna Arendt, sosteneva che la capacità della nostra “fantasia morale” (Anders 2012, 256), nell’era della tecnica, sia ormai ampiamente superata dalle possibilità del mondo macchinale: il massimo di ciò che possiamo immaginare è infinitamente più piccolo rispetto al massimo di ciò che – attraverso le tecnologie da noi stessi create – possiamo realizzare. È il dislivello prometeico (24). E se non riesco a immaginare le conseguenze di una mia azione (che verrà enormemente amplificata dall’apparato tecnologico), cosa dovrei fare? Nulla. Astenermi da qualsiasi azione le cui conseguenze non sono in grado di abbracciare con il pensiero.

Fermare per un po’ i laboratori che lavorano sulle IA a molti non sembra perciò un’idea peregrina. Non tanto perché ci si immagini chi sa quale cataclisma, ma proprio per il semplice fatto che intuiamo che qualcosa cambierà, ma non siamo del tutto in grado di immaginare che cosa e come. Tuttavia, l’appello non ha raccolto solo consensi: qualche voce critica si è destata. Yuk Hui, filosofo del digitale, ad esempio, in un tweet si è mostrato perplesso dalla richiesta di una moratoria di sei mesi che emerge dal documento. Cosa sono sei mesi a fronte delle ricerche, spesso inascoltate, portate avanti da decenni da accademici, dipartimenti, think tank, eccetera? Forse sarebbe il caso di prendere sul serio chi da molto tempo si interroga sulle tecnologie emergenti e sul loro rapporto con gli esseri umani, ritagliando un ruolo per enti e istituzioni che hanno già proposte di soluzione o quantomeno linee di ricerca e di riflessione avviate.

Ma non si tratta solo di volersi lamentare del fatto che il Future of Life Institute sia arrivato tardi: ci sono state anche contro-proposte alternative allo stop da imporre ai principali attori nello sviluppo delle IA. Uno è stato quello di Accessible AI, che ci invita a:

- Concentrarci su attuali tecnologie e attuali rischi ad esse connessi

- Riflettere in particolare su questioni quali privacy e trasparenza

- Incoraggiare uno “slow AI development”

Questa idea di uno sviluppo “lento” permetterebbe di non interrompere – e, anzi, incoraggiare – lo sviluppo dell’IA, ma di mantenerla “a misura umana”, utile, accessibile, trasparente.

Simile è l’idea alla base della lettera aperta che Privacy Network ha indirizzato al Parlamento Europeo. Tale lettera si concentra sulle sfide attuali che ci vengono poste dai modelli di IA, sfide di ordine morale, politico, ecologico, e invita, quindi, a pensare a regole da elaborare e applicare il prima possibile, più che a pause o a moratorie volte a riflettere sugli eventuali rischi futuri. Privacy Network; inoltre, si scaglia contro narrative futurologiche sull’obsolescenza dell’essere umano, le quali avrebbero l’unico effetto di distoglierci da problemi concreti e attuali.

La lettera del Future of Life Institute e quella di Privacy Network rappresentano i poli opposti, le narrazioni antitetiche che si affrontano sul campo dello sviluppo dell’IA e delle tecnologie più in generale. La prima si imbeve di una narrativa quasi fantascientifica sul potere intrinseco delle macchine, estraneo e sfuggente rispetto al controllo umano, che finisce per rappresentare una minaccia alla vita della nostra specie per come la conosciamo. La seconda è una visione più ottimista, seppur costantemente preoccupata per la situazione contingente, la quale osserva come le problematiche tecnologiche siano principalmente legate alla distribuzione del potere e come quest’ultimo sia sempre in mani umane.

Gli effetti dell’IA. Un esempio applicato al lavoro culturale

Anche alla luce di queste critiche o contro-proposte, una cosa va però riconosciuta all’appello sulla moratoria: sta aprendo un dibattito. Discutere di IA non solo dal punto di vista tecnico, ma anche di impatto sociale e – perché no? – da una prospettiva filosofica non può che far bene. Ma a me sembra che spesso, in questo dibattito, manchi un tassello che vorrei provare a inserire passando per un esempio.

Mi è capitato di parlare di recente con alcuni colleghi del possibile impatto di assistenti virtuali come ChatGPT sul nostro lavoro. Siamo ricercatori, lavoriamo in accademia. Di più: siamo ricercatori umanistici, il nostro lavoro, all’osso, è leggere e scrivere. Nel momento in cui ci troviamo ad avere a che fare con un agente artificiale in grado di fare, grosso modo, quello che facciamo noi, è abbastanza normale interrogarci sul futuro della professione.

Per carità, nessuno di noi ha in mente una possibile sostituzione dei ricercatori universitari con un esercito di chatbot. La riduzione del personale accademico ha ben altre – e meno futuristiche – cause. Tuttavia, come ogni nuovo medium, anche l’introduzione di assistenti basati sui più recenti sviluppi dell’IA provoca una riconfigurazione tanto delle competenze a noi richieste, quanto dei rapporti dei ricercatori tra loro e con le istituzioni con cui interagiscono.

Quindi, in che modo, innanzitutto, ChatGPT può cambiare il lavoro dell’accademico? Con IA come questa, anche se attualmente non è ancora del tutto possibile senza sbavature, presto diventerà molto facile costruire strutture argomentative di articoli per poi inserirvi dati di una ricerca o idee e teorie da discutere e commentare.

Siamo dunque destinati a essere sostituiti come scrittori? Forse in parte sì, ma non è questo il problema. Italo Calvino (2018, 201-221), già nel 1967, nel bellissimo saggio Cibernetica e fantasmi, ci diceva che, fondamentalmente, non esiste alcun problema nel pensare che una macchina sia in grado di fare della letteratura: la scrittura è, in fondo, arte combinatoria e chi può comporre tutte le possibili combinazioni di simboli sulla base di regole meglio di un computer? Ma, andando anche più indietro, è dalle tesi di Milman Perry sulla questione omerica che sappiamo che la letteratura è, in essenza, una combinazione di materiale linguistico a disposizione.

Dunque, che una macchina faccia parte del nostro lavoro non sarebbe di per sé un problema, ma, casomai, un sollievo: liberati dalla necessità di scrivere (senza che, per questo, ci venga tolta la possibilità di scrivere quando ci va), potremmo dedicare più tempo alla ricerca, all’elaborazione concettuale, all’osservazione, all’esperimento, insomma a tutti gli altri aspetti dell’attività scientifica.

E allora in cosa consisterà il cambiamento? Vi riporto due posizioni emerse dal confronto con i colleghi. La mia è più pessimista, quella di altri più ottimista. Partiamo dalla mia: già adesso ci viene richiesto di pubblicare in grande quantità, di massimizzare i prodotti della ricerca, di cercare di essere citati il più possibile: questo, spesso, va a scapito della qualità. Nel momento in cui avremo a disposizione uno strumento che ci permette di costruire articoli in meno tempo, la logica del publish or perish verrà portata alle estreme conseguenze in termini di quantità e rapidità di produzione di ricerca richiesta. Il risultato potrebbe essere stagnazione e ripetitività. Del resto, è un film già visto: la richiesta di produzione sempre più massiccia di ricerche è andata di pari passo con i mezzi tecnici che ci hanno facilitato le ricerche bibliografiche, la comunicazione di dati, la reperibilità di informazioni, eccetera.

Esiste tuttavia una visione più ottimista, quella difesa da alcuni miei colleghi: proprio perché sarà così facile produrre nuovo materiale, ciò che verrà premiato sarà l’originalità. Riprendendo il già citato saggio di Calvino (2018, 214): sebbene la letteratura sia arte combinatoria, in essa la novità si genera allorquando vengolo forzati i limiti del linguaggio, così da esprimere qualcosa che prima era inesprimibile. Allo stesso modo noi accademici nell’era di ChatGPT, alleggeriti dal compito della scrittura e della strutturazione, potremmo dedicarci all’autentica creatività: cercare l’idea nuova, forzare i limiti di quanto già disponibile (su cui opera la macchina) e dire il non detto, pensare l’impensato, scoprire qualcosa.

Per quanto questo modo di vedere abbia una sua logica e persino una sua fattibilità, io penso che soffra di un limite, che è un limite fondamentalmente politico: per affermarsi richiederebbe una diversa architettura istituzionale e una diversa logica di distribuzione dei fondi alla ricerca. Fintanto che la ricerca è un mercato, ad essere premiati saranno quantità e rapidità.

Se la rapidità sarà il criterio, è ovvio che le IA detteranno lo standard e saremo noi a diventare – per usare una terminologia adoperata da McLuhan (2015, 58) – il loro servomeccanismo, rifornendole di dati che loro elaboreranno. Si tratta quindi di un problema politico in un duplice senso: c’è un’architettura istituzionale che spinge verso una certa logica della produttività e c’è un’architettura tecnologica, progettata proprio a partire da quella stessa logica, che funziona in modo da perpetuarla. Il problema è quindi tecnologico e politico, o forse politico perché tecnologico.

System failure

Questo esempio, credo, illumina molto bene la questione dell’intreccio di politica, istituzioni e tecnologia che sta alla base di molte delle problematiche connesse all’IA. Se le istituzioni e la volontà politica rimangono legate al sistema politico-istituzionale-economico vigente ci troveremo senz’altro in una situazione in cui le IA – più brave di noi a trarre le logiche conseguenze del sistema che abbiamo approntato e ad amplificarle – sfuggiranno al nostro controllo. Perché, se è vero che la logica politica alla base della progettazione delle tecnologie è umana, è altrettanto vero che le tecnologie incorporano tali logiche, le fanno funzionare con un certo grado di autonomia e, come avrebbe detto Kittler (1996), finiscono per funzionare per escalazione, per portare alle estreme conseguenze le loro premesse, generando effetti imprevedibili.

Il sistema capitalista contemporaneo incentiva produttività e rapidità, non stupisce, dunque, che abbia progettato l’attuale architettura delle tecnologie digitali con l’obiettivo di perseguire tali scopi. Per questo la problematica di fondo non può essere aggredita né dal tecnosoluzionismo, che si illude di poter “aggiustare” e “correggere” con la tecnologia le tecnologie stesse quando queste danno risultati indesiderati, né la pressione istituzionale su istituzioni che fanno parte e non si sognano di mettere in discussione il sistema politico-economico vigente.

La battaglia tra gli appelli del Future of Life Institute e di Privacy Network è niente più che una scaramuccia tra riformisti. I primi propongono di fermarci un attimo, approntare possibili paletti o correttivi, per poi riprendere esattamente secondo la stessa logica attuale, così da massimizzare la produttività, salvando però il sistema di consumo. Del resto, la possibilità di profitto si basa anche sulla scarsità della merce, mentre la produzione di dati nell’era informatizzata è sovrabbondante. A questo “problema” i “capitalisti delle piattaforme” hanno finora ovviato appropriandosi delle infrastrutture e dei mezzi che permettono di estrarre valore dai dati prodotti dagli utenti e per questo non si possono permettere che l’IA rompa le dighe che loro hanno faticosamente eretto. Più che del “rischio esistenziale”, forse, Musk & Co. sono preoccupati per i loro portafogli e, forse, non è un caso che molti dei firmatari di quell’appello siano attori rimasti un po’ indietro nello sviluppo delle loro IA proprietarie.

I secondi sono senz’altro più in buona fede e non hanno bisogno di ricorrere a scenari apocalittici e fantascientifici per rilevare che, in effetti, esistono problematiche etiche e politiche già adesso e che queste richiedono di essere affrontate. Tuttavia, si affidano a decisori pubblici il cui ruolo potrà essere tuttalpiù quello di approntare strumenti legali atti a impedire violazioni nei confronti di singoli cittadini o gruppi, ma, soprattutto, di salvaguardare il sistema attuale, senza mettere in discussione né la proprietà delle infrastrutture e dei mezzi di estrazione di valore, né i rapporti tra centri di ricerca e laboratori che sviluppano IA e tecnologie e i loro finanziatori o compratori del prodotto finito.

Soltanto sottraendo la ricerca (sull’IA, ma non solo) alle logiche sistemiche, istituzionali, economiche e politiche vigenti si potrà pensare di risolvere alcune problematiche etiche attuali (la concentrazione di potere, l’impatto ecologico, le violazioni dei diritti umani, l’accentramento culturale e il colonialismo digitale, per citare quelle nominate nella lettera di Privacy Network), ma anche di progettare un futuro tecnologico differente. Solo progettando delle IA in maniera partecipata e decentrata, fuori dalle logiche della produttività, potremo davvero liberare il potenziale creativo e generativo dell’IA, andando contemporaneamente a liberare potenziale umano grazie all’IA.

Si tratta, lo dico senza alcuna vergogna, di un progetto utopico. E, come ogni utopia, è irrealizzabile… nella cornice del sistema contro il quale viene pensata. Né gli imprenditori dell’industria tech né i decisori pubblici delle liberaldemocrazie potranno andare in questa direzione, ma proprio per questo diventa tanto più necessario che le comunità interessate inizino a parlarne.